راهنمای اجرای مدل زبان بزرگ هوش مصنوعی روی گوشیهای قدیمی

- مها آدینه

- بدون نظر

میتوانید مدلهای زبانی بزرگ هوش مصنوعی را بهصورت محلی و آفلاین روی گوشی هوشمند اجرا کنید؛ درادامه، نحوه انجام این کار را بهشما آموزش میدهیم.

اجرای برنامههای جدید و پیشرفته روی سختافزارهای قدیمی، همیشه یک چالش است. همانطور که در مورد LLMها تلاش میشود، در مورد سایر اپلیکیشنها نیز این چالش وجود دارد. برای مثال، اگر یک آیپد قدیمی دارید و میخواهید برنامههای جدید را روی آن اجرا کنید که از iOS/iPadOS 16 پشتیبانی نمیکنند، میتوانید از آموزش نصب برنامه روی آیپد قدیمی استفاده کنید. این تلاشها نشان میدهد که چگونه جامعه توسعهدهندگان و شرکتها سعی میکنند تا فناوریهای جدید را برای طیف وسیعتری از دستگاهها قابل دسترس کنند، حتی اگر سختافزار آنها به روز نباشد.

گوشیهای هوشمند امروزی، درواقع کامپیوترهای جیبی قدرتمندی هستند که قابلیتهای آنها در بسیاری از جنبهها با کامپیوترهای رومیزی برابری میکند. از کاربردهای متنوع بهرهوری گرفته تا دنیای سرگرمی و بازی، این دستگاهها پتانسیل عظیمی را در اختیار کاربران قرار میدهند. یکی از این قابلیتهای شگفتانگیز، اجرای مدل زبانی بزرگ (LLM) بهصورت آفلاین و بدون نیاز بهاینترنت است. این موضوع بهمعنای دسترسی بههوش مصنوعی پیشرفته و پردازش زبان طبیعی در هر زمان و مکان، حتی بدون اتصال بهشبکه است. البته باید توجهداشت که برای اجرای روان این مدلهای پیچیده، نیاز بهیک گوشی هوشمند با سختافزار قدرتمند و بهروز دارید.

اگر قصد دارید هر مدل هوش مصنوعی را روی گوشی خودتان اجرا کنید، اولین نکتهای که باید بدانید آناستکه برای اجرای تقریبا هر مدلی، بهحجم قابلتوجهی از حافظه RAM نیاز دارید. این اصل اساسی، دلیل نیاز به VRAM بالا هنگام کار با برنامههایی مانند Stable Diffusion است و در مورد مدلهای مبتنی بر متن نیز صدق میکند. بهطورکلی، مدلهای هوش مصنوعی برای مدت زمان اجرای وظیفه در RAM بارگذاری میشوند که این فرآیند بهمراتب سریعتر از اجرای آنها از حافظه ذخیرهسازی است.

حافظه رم به دو دلیل عمده سریعتر است؛ اول اینکه تاخیر کمتری دارد، زیرا به CPU نزدیکتر است و دوم اینکه پهنای باند بالاتری دارد. بههمین دلایل، بارگذاری مدل زبان بزرگ روی حافظه رم ضروری است، اما سؤال بعدی که معمولا مطرح میشود آناستکه مدلهای زبانی دقیقا بهچه میزان رم نیاز دارند. Vicuna-7B یکی از محبوبترین مدلهایی است که هر کسی میتواند اجرا کند؛ همچنین، یک برنامه جهانی تحتعنوان MLC LLM بهاستقرار آن کمک میکند. این مدل زبانی بزرگ روی مجموعهدادهای از 7 میلیارد پارامتر آموزش دیده و میتواند ازطریق MLC LLM روی گوشی هوشمند اندرویدی مستقر شود. تعامل آن در گوشیهای هوشمند اندرویدی به حداقل 6 گیگابایت حافظه رم نیاز دارد که این روزها مقدار زیادی محسوب نمیشود.

نحوه استفاده از MLC برای اجرای مدلهای زبان بزرگ (LLMs) روی گوشی هوشمند شما

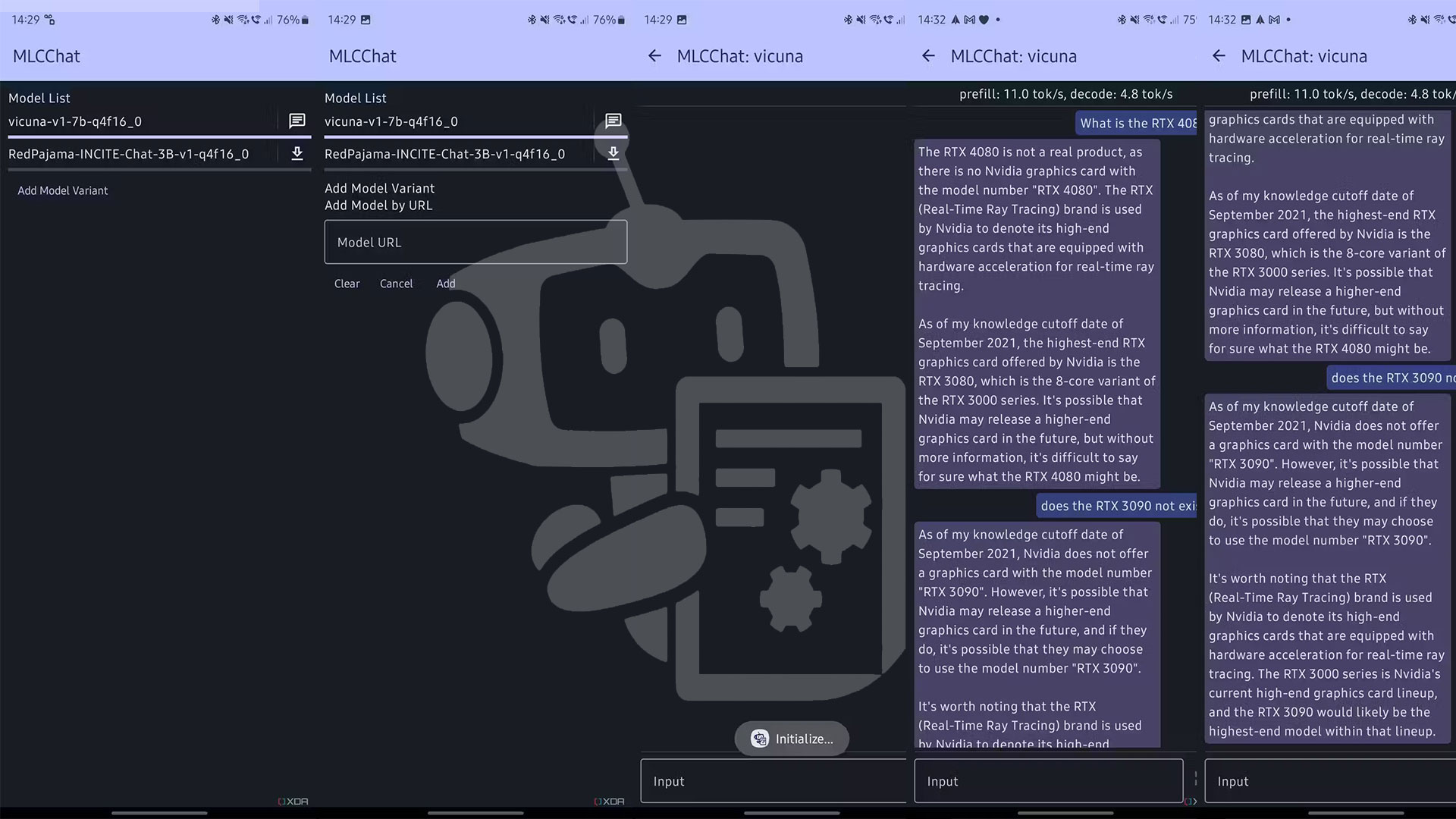

برای دانلود و اجرا مدلهای زبان بزرگ (LLM) هوش مصنوعی روی گوشی هوشمند خود، میتوانید برنامه MLC LLM را دانلود کنید. برنامهای که مدلها را برای شما مستقر و بارگذاری میکند؛ سپس امکان اجرای آنها را درون خود فراهم میسازد. بهعبارتدیگر، MLC LLM مسئولیت بارگذاری مدلها در حافظه RAM و اجرای آنها را برعهده میگیرد؛ برنامه MLC LLM را میتوان بهنوعی مشابه LM Studio، اما مختص گوشیهای هوشمند در نظر گرفت.

بهطور پیشفرض، MLC LLM از Vicuna 7B و RedPajama 3B پشتیبانی میکند، اما اگر تمایل بهآزمایش مدلهای دیگری دارید، میتوانید با ارائه آدرس اینترنتی مربوطه، مدل موردنظر را بهصورت دستی بارگذاری کنید. در پلتفرم Hugging Face میتوانید مدلهای متنوعی با اندازههای مختلف را بیابید که ارزش امتحان کردن را دارند. بااینحال، توصیه میشود از مدلهایی با پارامتر بیش از 7 میلیارد استفاده نکنید، زیرا احتمالا بهدلیل نیاز بهحجم بالای RAM، برای گوشی شما بسیار سنگین باشند.

برای نصب یک مدل هوش مصنوعی روی گوشی هوشمند خود، این مراحل را دنبال کنید:

- برنامه MLC LLM را دانلود و نصب کنید؛

- یکی از مدلهای پیشنهادی را دانلود کنید یا بهصورت دستی، مدل مورد نظر خود را از Hugging Face به برنامه اضافه کنید؛

- برنامه را اجرا کنید و منتظر بمانید تا مدل بارگذاری شود.

بههمین سادگی میتوانید یک مدل هوش مصنوعی را روی گوشیهای هوشمند نصب و اجرا کنید! اگر مشتاق بهتجربه فناوری هوش مصنوعی هستید، استفاده از برنامه MLC برای نصب و اجرای مدلهای زبانی بیشک بهترین روش است. همچنین، MLC در اپاستور پشتیبانی میشود و کاربران گوشیهای قدیمی آیفون میتوانند ازآن برخوردار شوند. ازطرفدیگر، پلتفرم بزرگ Hugging Face گنجینهای از مدلهای زبان بزرگ است که میتواند به آن دسترسی کامل داشته باشید.